Czym był Fred i jaki miał cel?

Fred stał się prekursorem nazewnictwa dla każdego nieokreślonego update’u algorytmu Google – nazwa wymyślona początkowo jako żart przez Gary’ego Illyesa zyskała na popularności i weszła do stałego użytkowania w środowisku SEO.

Aktualizacja algorytmu Fred została wprowadzona w celu znajdowania tego, co Google postrzega jako wyniki niskiej jakości – chodziło głównie o witryny, które opierały się na słabej treści i agresywnym, mnogim umieszczaniu reklam w serwisach www.

Kiepska jakość treści, według algorytmów Google dotyczy kilku sytuacji, takich jak:

- brak treści w serwisie, lub bardzo mała jej ilość,

- treści generowane automatycznie,

- treści kopiowane z innych serwisów,

- „keyword stuffing” – nagminne używanie słów kluczowych,

- ukrywanie treści na stronie,

- zbyt ogólne pisanie o konkretnych tematach (np. Ile kosztuje samochód? – Samochód nie jest tani, ale trudno określić, ile kosztuje, etc.).

Wiele z tych serwisów, których dotknęła aktualizacja algorytmu, było witrynami partnerskimi, uczestniczącymi w bardzo rozbudowanej sieci afiliacyjnej i znaczną część swojej przestrzeni poświęcały na reklamy, aniżeli dbały o jakość treści.

Agresywne taktyki monetyzacji, stosowane przez niektóre witryny, zdaniem Google, negatywnie wpływały na wrażenia użytkowników. Eksperci sądzą, że większość witryn, które straciły na Fredzie, ma podobne cechy, tj. słabe treści i agresywne reklamy.

Nie tylko zbyt intensywne, ale również i szkodliwe oraz „złośliwe” umieszczanie reklam, które jako cel miały wymusić kliknięcie przez użytkownika, np. za pomocą ukrycia przycisku „X”, mogło skutkować karami po wprowadzeniu Freda. Według niektórych celem były również słabej jakości linki zwrotne w serwisach. Oznacza to, że linki zwrotne do stron o słabym autorytecie domeny, nieaktualne, uszkodzone lub „nienaturalne” były dla Freda istotne tak bardzo, że niektórzy eksperci uważają, że jakość linków stała się cechą definiującą całą aktualizację.

Interesujące również jest to, że FRED zbiegł się w czasie z aktualizacją Google, która została skupiona wokół E-A-T.

Dla przypomnienia:

E – Expertise

A – Authoritativeness

T – Trustwothiness

Słynne Google’owe „jedzonko” opiera się na

– jakości,

– eksperckości,

– autorytatywności,

– wiarygodności,

Ale o tym więcej w innym artykule. 😊

Czego dotyczył FRED?

Fred nie był dramatycznym krokiem z dnia na dzień, ale raczej zwiększonym dostrojeniem zmian algorytmicznych, które już miały miejsce. Zbliżenie czasowe FRED-a i E-A-T mówi nam, że obszary serwisów objęte aktualizacją dotyczyły elementów, takich jak:

- zbyt duża liczba reklam w serwisie,

- słabej jakości treści,

- mało treści w serwisie,

- zbyt dużo afiliacji,

- reklamy jako treść,

- kiepski profil linków,

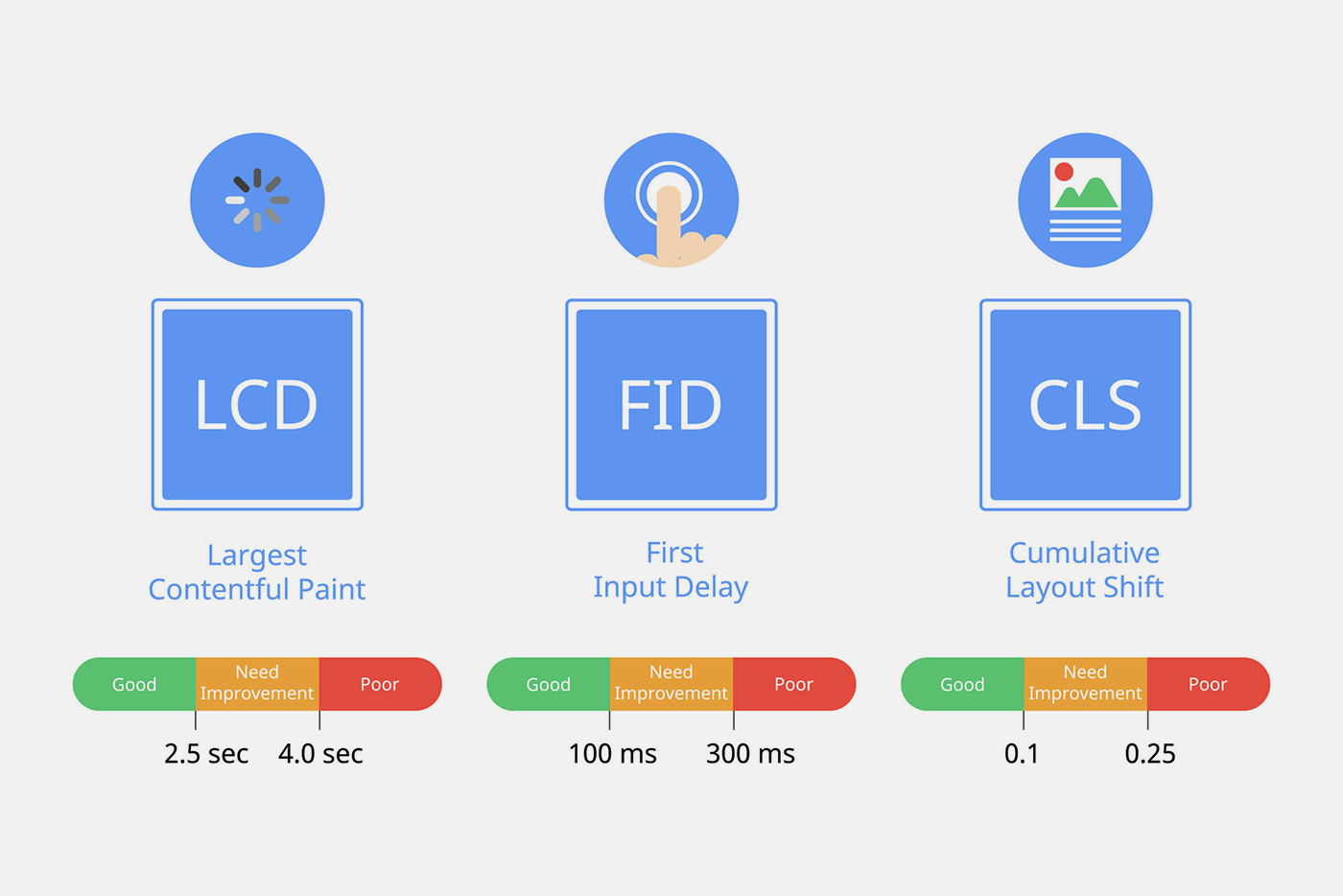

- słaba jakość techniczna serwisu.

Interesujesz się update’m? Google nie lubi tego

Według eksperta Google Gary’ego Illyes’a, który w kontekście FRED’a z marca 2017 wypowiadał się w tej materii – nie jest dobre to, że ludzie skupiają się na każdej poszczególnej aktualizacji z dużym namaszczeniem. Jako argument opiera się na fakcie, że każda aktualizacja ma na celu jak najlepsze promowanie najbardziej jakościowych witryn. Według Gary’ego istotne jest, aby twórcy stron poświęcali więcej czasu na zaspokajaniu potrzeb użytkownika i poprawianiu jakości serwisu, aniżeli na analizie aktualizacji i tym, które kryteria są aktualnie dla algorytmu najważniejsze pod kątem widoczności.1

Gary kluczy, omija i nie mówi nam wszystkiego. Można jednak z filmu wskazanego w przypisie wyciągnąć pewne oczywiste kwestie, takie jak to, że:

– większość aktualizacji nie daje możliwości podjęcia działań (w tym sensie, że mało konkretnych działań można zrealizować, aby szybko uporać się z efektami aktualizacji),

– widoczność organiczna wszystkich witryn podlega wahaniom,

– warto przejrzeć wskazówki dla webmasterów w celu stałego ulepszania swojego serwisu.

Należy wspomnieć, że stałe ulepszanie serwisów dzięki wskazówkom dla webmasterów jest w naszej opinii lepsze, aniżeli czatowanie na nowe aktualizacje algorytmów i efekty z nimi związane. Wykorzystanie uczenia maszynowego działa w służbie ciągłej aktualizacji algorytmów, co powoduje, że eksperci SEO niejednokrotnie nie są w stanie zidentyfikować zakresu aktualizacji nawet kilka tygodni po fakcie jego opublikowania.

Jak się podnieść po Fredzie?

Ci, którzy chcieli odzyskać widoczność po tej aktualizacji, mieli przed sobą bardzo trudne zadanie. Zazwyczaj musieli ponownie sprawdzić strukturę swojej witryny, aby zredukować liczbę reklam, a ponadto ponownie przeglądać treść — strona po stronie — aby upewnić się, że faktycznie jest tam content wysokiej jakości.

Czy to z powodu złej jakości linków, nadmiernego umieszczania reklam, wątłych treści, czy też kombinacji tych trzech — Fred był bardzo uciążliwy dla wielu witryn. Oczywiście można to uznać za dobrą sytuację dla użytkowników, co przecież jest teoretycznie celem Google. Po Fredzie aktualizacje dotyczące jakości pojawiały się częściej i były bardziej zróżnicowane. Można przypisać to rozwojowi uczenia maszynowego.

Życie w ciągłym strachu przed kaprysami Google od dawna jest normą dla specjalistów SEO, ale jest kilka środków, które warto rozważyć, by żaden update nie był straszny.

W punktach wygląda to tak:

- koncentracja na ogólnej jakości witryny,

- audyt techniczny serwisu w celu wyłapania problemów teraz i w przyszłości,

- zwiększona dbałość o jakość treści na stronie,

- czysty profil linków bez toksycznych i niskiej jakości powiązań,

- unikanie zbyt dużej liczby reklam na stronie.

Niektórzy webmasterzy na forach internetowych zgłaszali kolejne wzrosty ruchu po usunięciu lub znacznym zmniejszeniu zasobów reklamowych w serwisie, wzmacniając związek między wzmożonymi praktykami reklamowymi a karami od Google.

Dywagacje na temat Freda

Niektórzy eksperci uważają, że w przypadku Freda mamy do czynienia z połączeniem aktualizacji Pingwin i Panda. Witryny z niską zawartością mają zazwyczaj kiepskie praktyki związane z linkowaniem i są często przeładowane reklamami. Porównać można to do sytuacji, gdy Pingwin i Panda śledzą takie serwisy, a następnie są one degradowane z powodu złych praktyk, słabej treści i złego linkowania.

Dla szybkiego przypomnienia:

Panda (2011) – algorytm sprzeciwiający się: „farmom treści”, contentowi słabej jakości i małej ilości treści w serwisach,

Pingwin (2012) – algorytm sprzeciwiający się: spamlinkom i black hat linkbuildingowi.

Eksperci twierdzą jednak, iż podstawowym czynnikiem, na który uwagę miał zwrócić Fred, była jakość serwisów dla użytkownika, a przede wszystkim walka z agresywnymi taktykami monetyzacji, które powodowały złą ocenę i wrażenia internautów.

Biorąc pod uwagę ogół, nie jest istotne konkretnie to, który z czynników aktualizacji Fred był kluczowy – ważny jest natomiast zakładany cel, która powoduje, iż dzięki tej aktualizacji użytkownicy mogą dużo zyskać na jakości odwiedzanych serwisów.

Fred to tylko żart

Wielu ekspertów ma również przekonanie, że aktualizacja Fred to tylko żart wymyślony przez Illyesa zmęczonego ciągłymi dopytywaniami łowców update’ów, zaś fakt, że Google dokonuje mnóstwa aktualizacji w roku, nie może świadczyć o tym, że każdy z nich będzie przełomowy i trzeba robić z niego wielkie halo.

Podsumowanie

Fred jako mit, czy jako fakt nie powinien zmieniać podstawowej zasady budowania i opieki nad witrynami w sieci, które muszą dostarczać użytkownikowi jak najlepszą jakość i generować jak najwyższą wartość.

Zarówno specjaliści SEO, webmasterzy, developerzy czy właściciele podstron, którzy budują swoje strony w sposób optymalny, zgodny z dobrymi praktykami jak i zasadami nie powinni obawiać się o swoje witryny przy żadnej aktualizacji algorytmu.

Tak wygląda teoria – a w praktyce następny update, jak zwykle, może sporo namieszać. 😉

Źródła: